AI 변곡점에서 투자 이정표 - 메리츠증권 - 2025.02.06

딥시크 모먼트: 고성능 AI LLM의 상품화. 여기서 비롯된 AI 가격 하락

상품화된 고성능 모델 기반의 AI S/W 응용 확장 → AI 금융, AI 헬스케어 시장 주목

AI 모델 속도 경쟁 → AI H/W: 저전력 추론 연산 프로세서(ASIC), 네트워크 시스템 수혜 예상

딥시크 모먼트: AI LLM의 ‘상품화’

딥시크 R1에 출시에 기민하게 대응하는 OpenA

딥시크 충격 이후 가장 바쁜 기업은 OpenAI로 보인다. 시장이 딥시크 R1을 인지 한 1월 27일

이후 1주일도 안되어 OpenAI는 새 AI 모델 o3-mini를 공개했다.

여기서 멈추지 않고 더 정교하고 뛰어난 성능을 가진 Deep research를 바로 출시하면서

AI 모델 경쟁에 박차를 가했다.

덕분에 AI 모델 성능 향상 속도는 변곡점을 맞이함

딥시크 출현 이전과 이후, 새로 공개되는 모델의 기능 향상 속도가 다르다.

AI를 평가하는 모델 중 가장 어려운 것으로 알려져 있는 ‘Humanity’s Last Exam

(인류 최후의 시험)’ 성적 기준으로 보면, 딥시크 이전까지 AI 모델이 등장한 이후 가장 진보된

모델이라는 o1의 정답률이 10%가 되지 않았다.

딥시크가 공개되면서 새로 공개된 모델로 인해 불과 4개월만에 이 시험에 대한 최신 AI 모델의

정답률은 25%까지 급상승했다.

고성능+가격 하락 경쟁. 높은 유용성 레벨에서 상품화된 AI

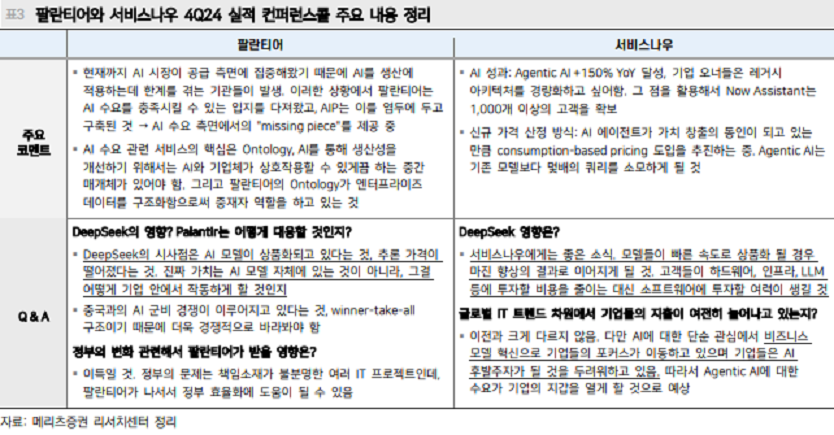

팔란티어 CTO 샴 산카르는 이번 실적 발표회에서 딥시크 R1의 명백한 교훈 중 하나는

AI 모델이 상품화(Commodity, 대체 가능하고 공급자 관계 없이 동일한 가치와 특성을 가지는

제품을 의미, 일반화되고 대중이 쉽게 이용 가능해진 상태) 되고 있는 것이라고 말했다.

Generative AI 단계에서의 모델들의 상품화는 계속 진행 중이었지만, R1 모델이

이런 흐름을 대중에게 각인시킨 효과가 큰 것이다.

‘이 가격에 이정도 성능을?’ 딥시크 충격이 컸던 이유는 ‘꽤나 쓸모 있는 수준’까지 발전한

AI 성능도 한 몫 했을 것

R1의 각인 효과가 컸던 이유는 낮은 비용도 중요했지만 모델의 ‘실력’도

중요했던 것으로 생각한다.

AI 모델이 수준이 ‘꽤나 쓸모 있는’ 수준에 도달하기 시작했기 때문이다.

새로 공개된 o3-mini 모델도 딥시크보다 저렴한 API 비용이 필요한, 박사 수준의 전문가

지식을 갖춘 모델이다(GPQA 벤치마크 점수 기준). o1 모델이 유사한 성능이었지만,

비용(그림 3)을 고려하면 딥시크의 R1과 o3-mini는 낮은 비용으로 쓸모 있는 높은 수준의

성능을 갖춘 최초의 모델인 것이다.

코딩 작업에서의 AI의 효용성도 2년 사이 급격한 발전을 이루었다

AI 인프라 → 소프트웨어 중심으로 AI usage 포트폴리오 전환 가속

고성능 AI의 범용화 → AI usage로 포트 전환 가속

우리는 작년 11월부터 2025년에는 AI 인프라 포트폴리오(표 1)에서 AI usage

포트폴리오(표 2)로의 전환 타이밍이 핵심이라고 주장하고 있다.

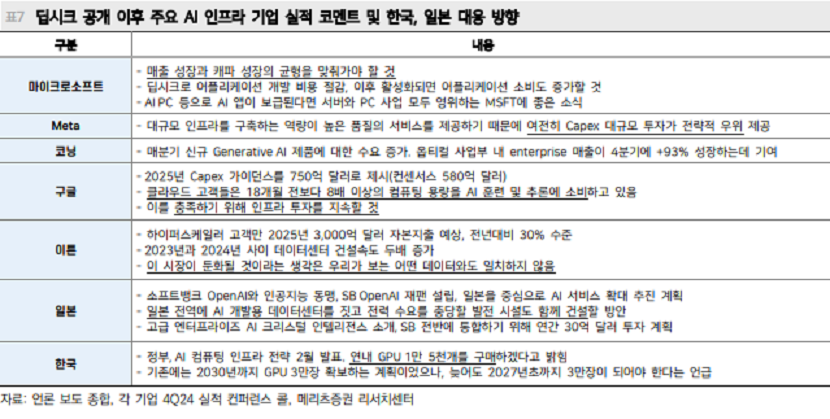

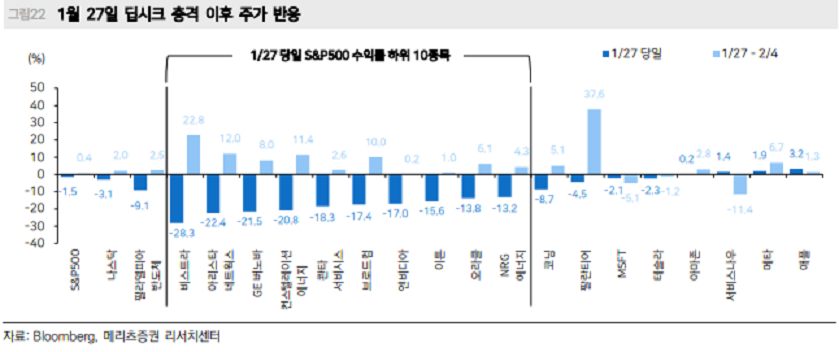

1월 중순 트럼프 정책이 나올 때까지만 하더라도 AI 인프라 포트폴리오 흐름이 강화되는 듯

했으나, 딥시크 모먼트로 포트폴리오의 전환 타이밍이 가속화된 것으로 판단한다.

AI 성능 체험이 늘수록 AI B2C 인기는 커질 것

딥시크 모먼트로 AI 성능을 체험한 사람들을 중심으로 AI B2C 확산은 빨라질 것이고

AI usage(AI의 활용; 소프트웨어/자율주행/로봇) 관련 종목들의 ‘인기’도

계속 커질 것으로 생각한다

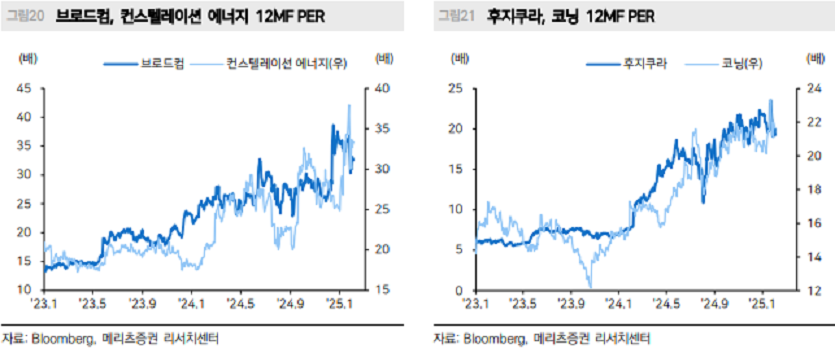

우상향 고밸류 주식 = 주도주

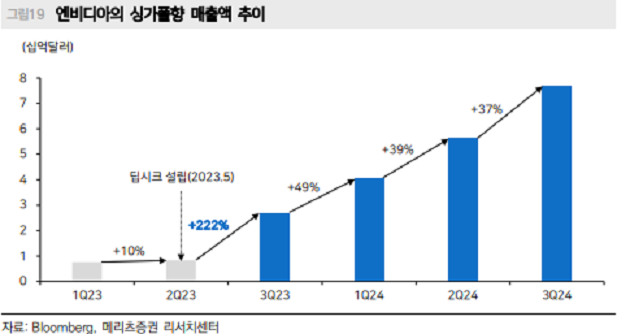

엔비디아는 2년간 시장을 이끈 주도주였는데, 실적의 고속 성장에도 밸류에이션은 IT 섹터

평균까지 하락했다.

반면, 팔란티어는 테슬라처럼 고밸류에이션을 계속 영위하며 주가가 급등 중이다.

너무 높은 밸류에 우려의 시선도 많지만 고밸류를 계속 정당화하며 주가 상승 흐름이 이어진,

최근 5년 사이 주도주였던 테슬라, 엔비디아의 흐름을 상기해봐야 한다.

AI 인프라는 독점 구도 → AI 모델의 상품화에서는 수혜 종목의 확산 구도

팔란티어 Peer인 서비스나우는 주가 차별화 되었으나

우리가 포트폴리오에 주목했던 종목 중 팔란티어와 서비스나우는 4Q24 실적발표 이후 주가

흐름이 차별화되었다.

팔란티어는 시장 기대를 상회하는 실적과 긍정적이고 자신감 있는 가이던스로 주가 상승이

가팔랐으나, 서비스나우는 실적 미스에 따른 주가 하락이 나타났다.

AI의 최적 적용을 기반으로 하는 팔란티어는 지속적인 고객사 증가 속도에 기반해 주가 상승

가도를 이어가고 있다.

반면 서비스나우는 4Q24 구독 매출 컨센서스 하회, 연간 구독 성장률 전망치도

시장 눈높이를 하회하면서 주가가 하락했다.

AI 상품화에 따른 가격 하락 수혜 확산시 기회 고려

다만 컨콜에 따르면 AI 비용 하락은 서비스나우의 마진 개선 요인이다.

여기에 해당 회사의 고객 기업들이 자체적으로 하드웨어에 투자하기보다 저렴해진

소프트웨어를 구매(서비스나우 소프트웨어 구매)하게 되는 변화까지 기대해볼 수 있다.

AI 상품화, 비용 절감 수혜 산업의 확장: AI 금융, 헬스케어

누적된 AI 하드웨어 투자가 기여한 AI 상품화

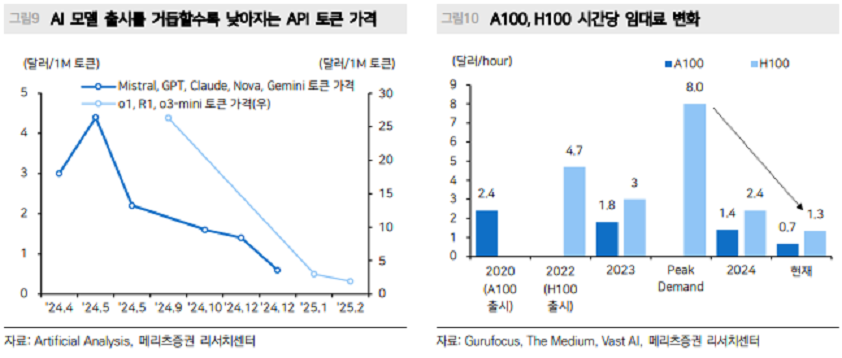

새로운 AI 모델의 기술 진보가 기본적인 가격 경쟁의 밑바탕이며, 여기에 AI 하드웨어 투자의

누적도 AI 추론 가격 하락에 영향을 주었을 것이다.

핵심 AI 연산 프로세서인 H100의 시간당 임대료는 2024년 피크 시점 8달러에서 최근 1.3달러까지

1/6 수준으로 하락했다.

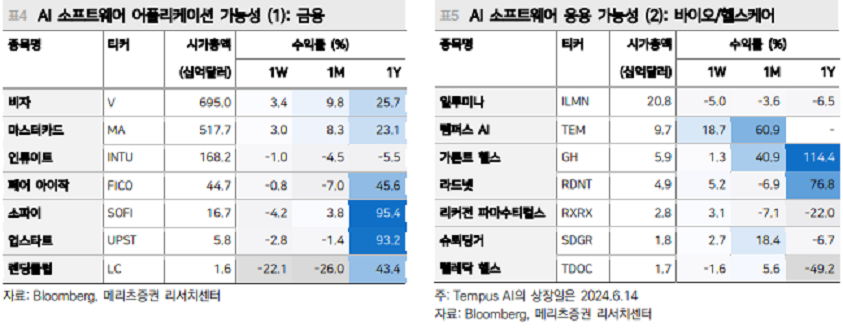

AI 상품화 → 비용절감 수혜, AI 금융/헬스케어 주목

AI 추론 가격 하락, AI의 상품화 국면에서 아이디어의 확장은 AI 파운데이션 모델을 활용해 특정

분야에 응용하는 AI 어플리케이션 분야까지 수혜 확장을 기대할 수 있다.

대표적인 분야로 AI 금융 결제 시스템, 바이오/헬스케어 분야를 주목해 볼 수 있다.

AI 기술을 응용해 정밀 의학 솔루션을 제공하는 Tempus AI는 펠로시 전 하원의장의 거래 내역이

공개되며 1월에 주가가 급등하기도 했다.

딥시크 모먼트에서 AI H/W의 기회

큰 틀에서는 AI S/W 확산은 AI H/W의 확산도 유발할 것

주식시장의 관심이 AI 소프트웨어로 집중되는 상황에서 AI 하드웨어의 기회도 재점검해야 한다.

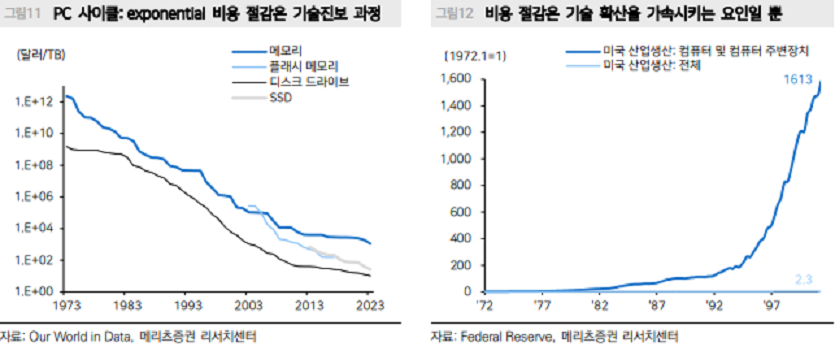

제본스의 역설은 기술 발전이 자원 활용 효율성을 높이면 오히려 자원 소비가 증가함을 의미한다.

지금 AI도 마찬가지로 AI 추론 가격 하락에 따른 AI 하드웨어 활용의 효율성이 높아지면,

AI 하드웨어 활용량의 증가로 이어질 것이다.

직전 거대 기술 사이클이었던 PC 사이클에서는 PC 가격의 하락이 보급을 가속화시키며

산업의 전체 규모를 키웠다.

AI ASIC, 네트워크 시스템 스토리 가속화 가능성 고려

시장의 관심이 현재는 AI 소프트웨어에 집중되고 있지만, 큰 틀에서는 AI 하드웨어의

동반성장도 염두에 두어야 한다.

딥시크 모먼트로 인해 주식의 인기 관점에서 2023년 초부터 시장을 주도했던 AI GPU(엔비디아),

AI CSP(구글, 마이크로소프트, 아마존)의 독점 프리미엄은 희석될 수 있지만, 그 다음 이어진

AI 하드웨어 사이클(ASIC, 네트워크 시스템)은 AI 경쟁을 위한 Capex 투자 가운데 모멘텀이

가속화될 가능성이 있다.

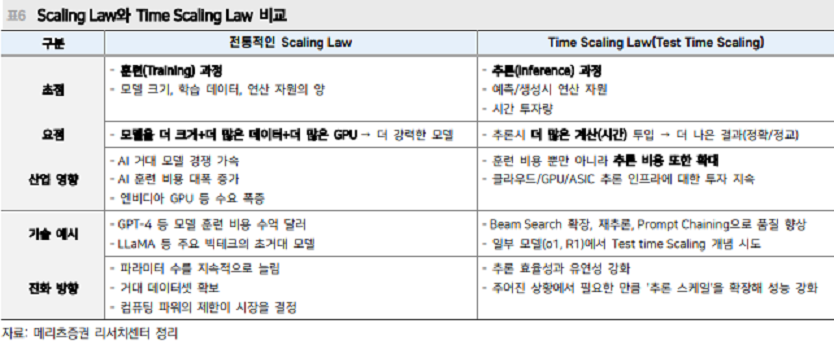

Scaling Law: 학습 단계의 더많은 컴퓨팅 자원 → 더 나은 모델

Time Scaling Law: 추론 단계의 더많은 시간 → 더 나은 결과

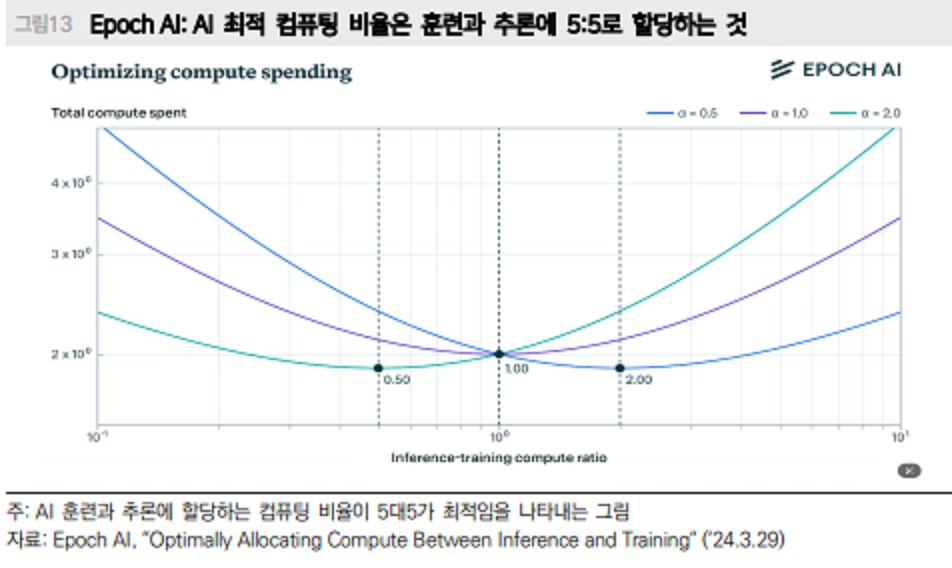

지금까지의 AI 모델 성능 향상 방정식인 Scaling Law에서는 1) 학습 단계에서 2) 더 많은 AI

학습 자원(모델 파라미터 수, 학습 데이터, 연산 자원(컴퓨팅 프로세서))이 확보될수록 더

강력한 AI 모델을 만들 수 있다.

이와 대비되는 Time Scaling Law는 1) 추론 단계에서, 2) 더 많은 계산 시간을 투입하면 더 나은

결과를 도출할 수 있다는 법칙이다.

이 기술이 적용된 모델은 생각하는 과정을 거쳐 적게는 수 초, 길게는 수십 초간 ‘생각’을

하다가 답을 내놓는다.

Time Scaling Law 하에서는 AI 훈련 비용은 줄일 수 있지만, 추론에 필요한 인프라와 비용이

더 필요하게 된다.

o3-mini도 추론 과정이 있음, 최신 모델 경쟁 트렌드는 Test Time Scaling이 전제된 것으로 추측

더 적은 비용으로 R1과 유사한 성능을 발휘하는 OpenAI의 새 모델 o3-mini도

추론 과정을 갖는다.

즉, 최신 모델의 경쟁 트렌드는 Test Time Scaling이 전제되어 있는 것으로 보인다.

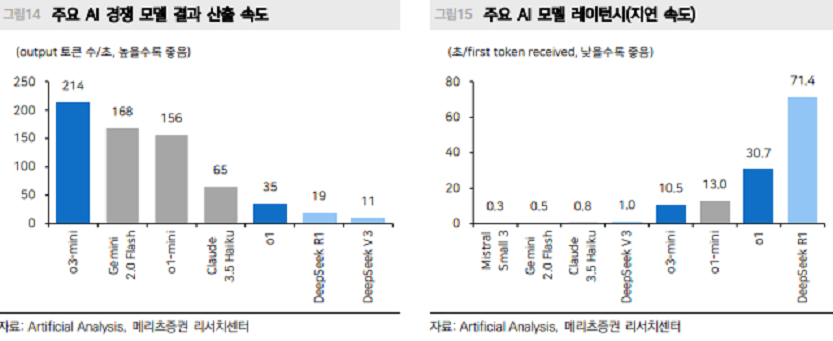

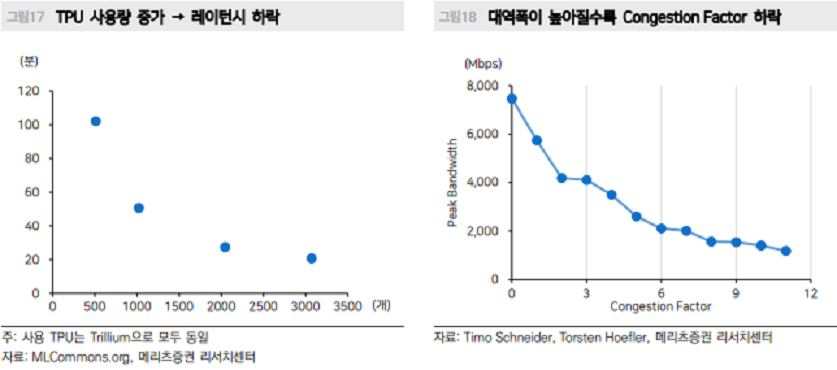

o3-mini의 경우 R1보다 더 빠른 결과 산출 속도, 더 낮은 레이턴시를 보여주는데, o3-mini 기반

모델(아마 o3일 것)의 높은 성능이 배경이 되어 추론 연산량을 낮춰도 기존 모델들의 성능과

유사하기 때문에 더 빠른 속도로 경쟁할 수 있는 것으로 해석된다.

이는 기반 모델 성능의 중요성과 distillation의 유용성을 의미한다

Test Time Scaling이 트렌드라면, 향후 AI 모델 경쟁의 핵심은 ‘속도’일수도

Test Time Scaling이 트렌드라면, 추론 시간 감축 여부가

향후 경쟁 요인일 수 있다고 생각

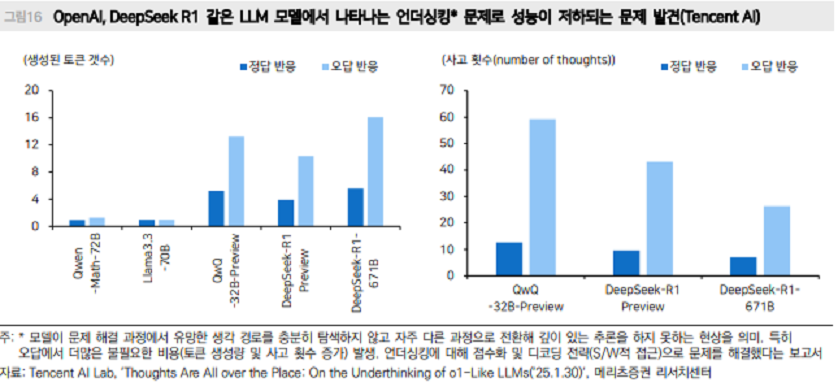

AI 모델에 투입되는 학습 비용을 낮추고, 추론 과정에서 성능을 향상시키는 Test Time Scaling이

AI 상품화 국면에서 모델 개선의 트렌드로 자리잡는 기술이라면, 향후 모델간 차별화의 핵심은

속도일 것으로 생각한다.

일정 수준 ‘쓸모 있는 수준’에 올라 서 있는 모델들의 수준을 고려하면, 비용 경쟁과 함께

부각될 수 있는 포인트는 모델이 생각하는 시간을 얼마나 줄일 수 있는 지일 것이다.

하드웨어 측면에서는 더 많은 프로세서를 투입하거나, 네트워크를 업그레이드 하거나

AI 모델의 속도를 개선시키는 일은 소프트웨어 개선과 하드웨어 개선 둘 다 가능하다.

소프트웨어 측면에서는 예를 들어 최근 Test Time Scaling이 적용된 모델에서 불필요한 추론

과정으로 비용을 유발하는 문제가 있어서, 강화학습 과정에 의도한 방향으로 보상을 주는

소프트웨어적 기술로 보완했다는 이야기가 있다.

하드웨어 측면에서는 더 많은 프로세서를 활용하거나, 네트워크 대역폭을 키우면

속도 개선이 가능하다.

AI 상품화 국면에서도 AI Capex가 필요한 이유

딥시크 R1과 이후에 출시된 o3-mini 모델의 경쟁 구도를 정리해 보면, AI 상품화 과정 속

모델들의 경쟁 과정에서 AI 하드웨어 투자가 필요함이 드러난다.

1) 기반 모델의 진보는 간소화 모델의 경쟁력에도 영향을 미치고, distillation을 통한 모델

개선까지도 고려하면 기반 모델의 성능 향상이 필요하고, 기본적인 GPU와 AI 기반의

Scaling Law는 여전히 유효하다.

2) 다만 1)보다 더 가속화를 기대할 수 있는 부분은 ‘추론 수요’이며, Test Time Scaling의

특성까지 고려해도 추론 수요 중심의 AI Capex 확장이 기대된다.

3) Time Scaling Law 기반의 모델 경쟁은 결국 ‘속도’ 경쟁일 것이고 추론 연산에 더 많은

하드웨어 투입, 통신 네트워크 개선으로 경쟁력을 확보할 수 있다.

ASIC, 통신 네트워크 관련주 중심 AI H/W 투자 유효

추론 중심의 AI Capex 확대 기대

GPU는 연산 속도, 효율 측면에서 ASIC 대비 불리하지만, 다양한 연산을 유연하게 할 수

있다는 장점이 있어 ASIC 대비 AI 학습에 유리하다. 반면 ASIC은 상대적으로 저전력, 고효율,

속도 측면에서 GPU 대비 AI 추론에 유리하다.

2월 4일 구글 실적발표 이후 Capex 계획 확대에 엔비디아의 주가반응보다 브로드컴의 주가

반응이 강했던 이유는 AI 추론 수요 중심의 Capex 확대에 대해서는 여전히 기대가 있고,

‘인기’가 살아 있는 것으로 생각한다

ASIC, 네트워크 관련주의 기회

팔란티어처럼 PER이 우상향 추세에 여전히 남아있는 주식에 관심을 갖는다면, ASIC과 통신

네트워크 관련주들은 AI 하드웨어에 대한 관심이 소홀해진 시점이 오히려

기회일 수 있다는 의견이다.

'주식시장 투자전략' 카테고리의 다른 글

| KOSPI 주도주에 대한 단상 (0) | 2025.02.21 |

|---|---|

| 혼란의 K칩스법, 소부장을 부탁해! (1) | 2025.02.13 |

| 관세는 핑계일 뿐이다 (0) | 2025.02.04 |

| FLNC: AI 수혜주 찾기에 재조명될 ESS 시장 (0) | 2024.05.09 |

| 수출을 보면 답이 보인다 : Stay in market with U.S (0) | 2024.04.24 |